第一个 Gemma 模型于去年年初推出,此后该模型不断发展,逐渐形成一个生机勃勃的 Gemmaverse 生态系统,拥有超过 1.6 亿的集体下载量。这个生态系统包括我们十几个专业模型系列,覆盖从安全防护到医疗应用的各领域。其中,最鼓舞人心的是来自社区的无数创新。从像 Roboflow 这样的创新者构建的企业层面计算机视觉,到东京科学研究所创建的高性能的日本 Gemma 变体,大家的工作为我们展示了未来的发展路径。

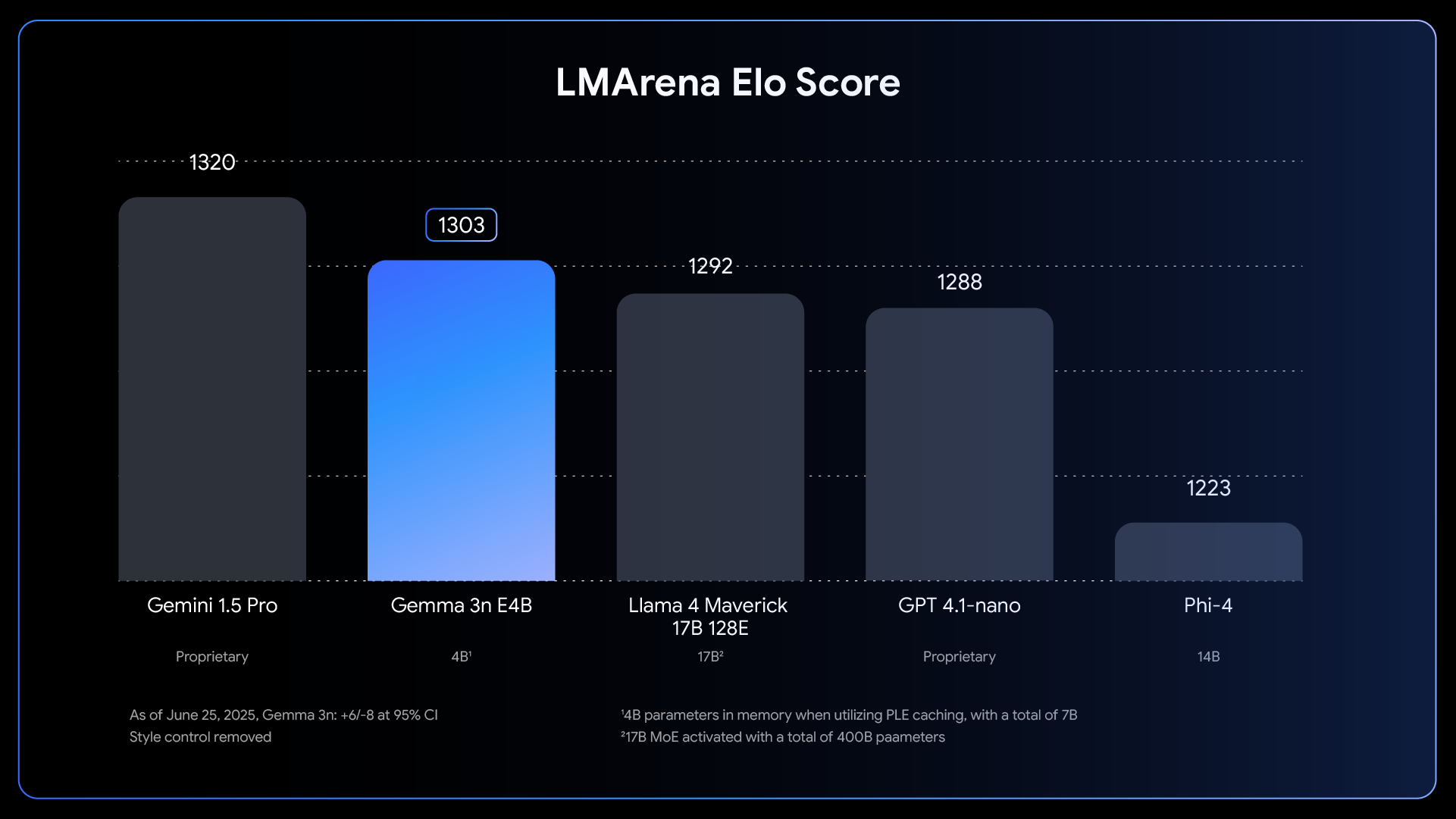

趁着这一激动人心的良好发展势头,我们很高兴地宣布:Gemma 3n 现已全面发布。虽然上个月的预览版已先行展示了一些功能,但这一移动设备优先架构现在能够发挥出全部的潜能。Gemma 3n 为帮助塑造 Gemma 的开发者社区而生。包括 Hugging Face Transformers、llama.cpp、Google AI Edge、Ollama 和 MLX 在内,您熟悉和惯用的多种工具都支持该模型,让您能轻松针对特定的设备端应用进行微调和部署。这篇文章将以开发者视角深入探索,介绍 Gemma 3n 背后的一些创新,分享新的基准测试结果,并告诉您如何立即开始构建。

Gemma 3n 代表了设备端 AI 的重大进步,为边缘设备带来了强大的多模态功能;过去,这些性能仅有去年基于云的一些前沿模型才能实现。

Link to Youtube Video (visible only when JS is disabled)

要实现这种设备端性能的飞跃,需要对模型进行彻底的重新构思和设计,其基础是 Gemma 3n 独特的移动设备优先架构,而这一切都始于 MatFormer。

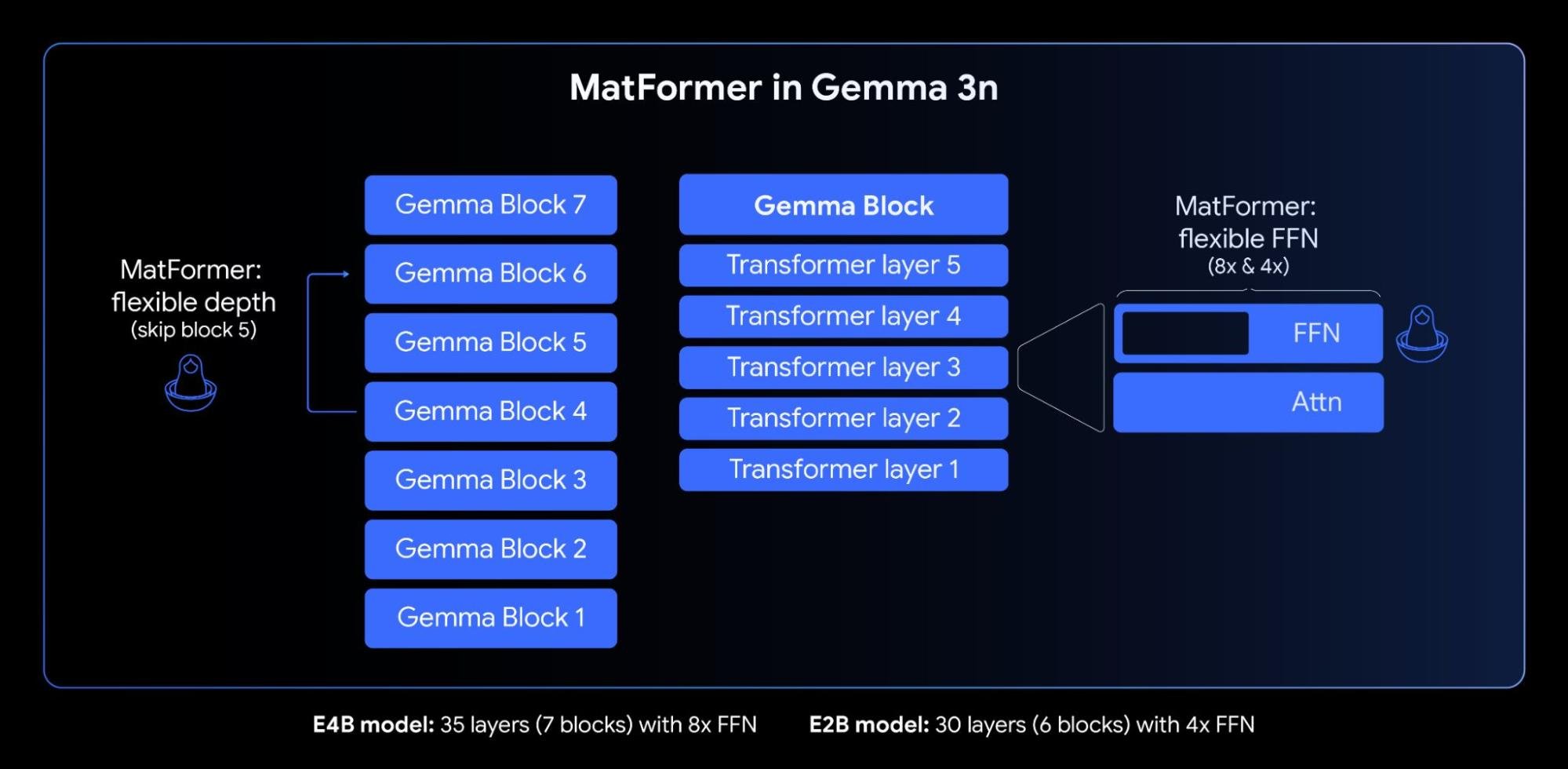

Gemma 3n 的核心是 MatFormer (🪆Matryoshka Transformer) 架构,这是一种专为弹性推理而构建的新型嵌套转换器。不妨把它想象成俄罗斯套娃:较大的模型中嵌套着该模型较小的、功能齐全的版本。这种方法将 Matryoshka 表征学习的概念从嵌入扩展到所有转换器组件。

在 4B 有效参数 (E4B) 模型的 MatFormer 训练期间,其中的 2B 有效参数 (E2B) 子模型也在同时进行优化,如上图所示。这在当下为开发者提供了两种强大的功能和用例:

1、预提取的模型:您可以直接下载并使用主 E4B 模型以获得最高级的功能,也可以使用我们已经为您提取的独立 E2B 子模型,获得主模型 2 倍的推理速度。

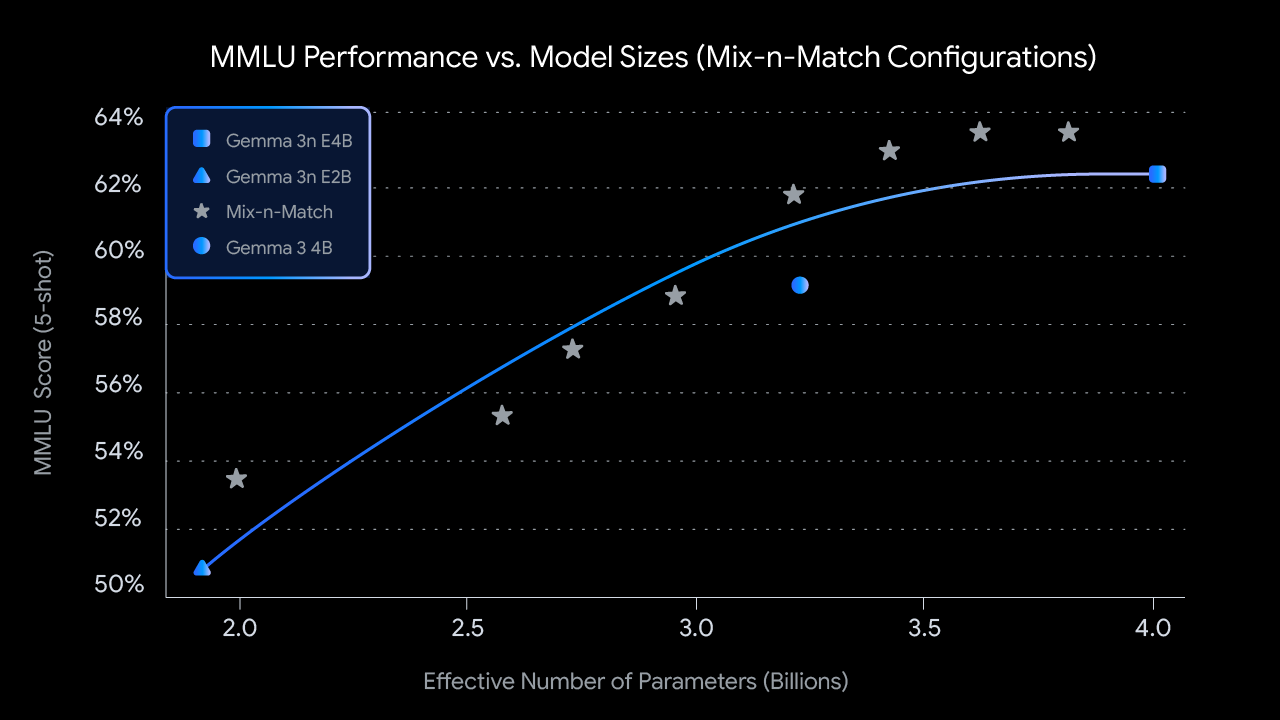

2、使用混合匹配 (Mix-n-Match) 自定义调整尺寸:为了根据特定的硬件限制进行更精细的控制,您可以使用我们称之为“混合匹配”的方法,创建一系列尺寸介于 E2B 和 E4B 之间的自定义尺寸模型。此技术允许您精确切片 E4B 模型的参数,主要是通过调整每层前馈网络隐藏维度(从 8192 到 16384)并选择性地跳过某些层来实现。我们即将发布 MatFormer Lab,该工具可演示如何检索这些最优模型,这些模型是通过在 MMLU 等基准上评估多种配置而被识别出来的。

展望未来,MatFormer 架构也为弹性执行铺平了道路。虽然此功能不是今天推出的实现的一部分,但它允许单个部署的 E4B 模型在 E4B 和 E2B 推理路径之间动态切换,从而根据当前任务和设备负载,实时优化性能和内存用量。

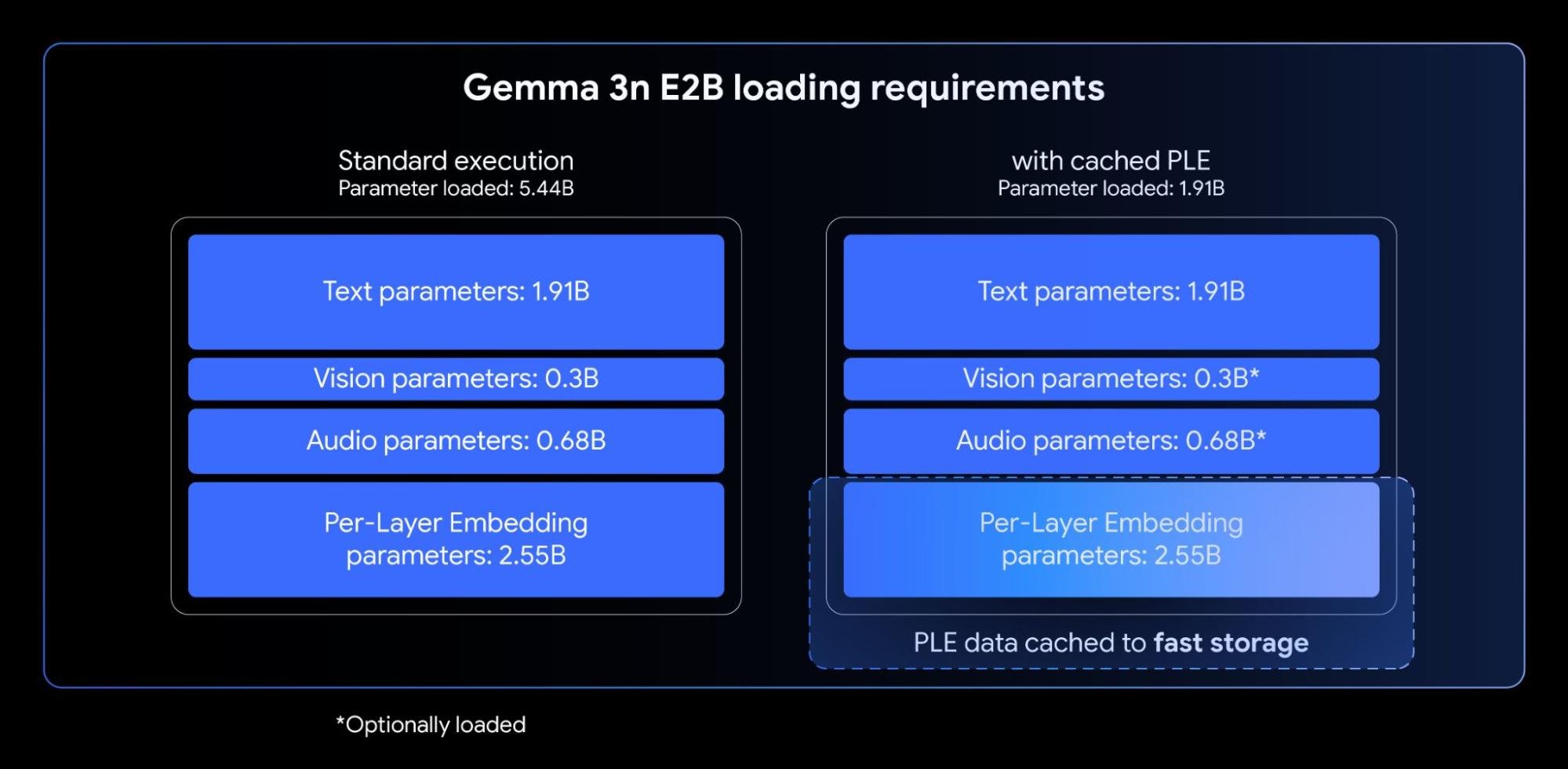

Gemma 3n 模型包含分层嵌入 (PLE)。这项创新专为设备端部署量身定制,因为它在不增加设备加速器 (GPU/TPU) 所需的高速内存占用量的情况下,显着提高了模型质量。

虽然 Gemma 3n E2B 和 E4B 模型的总参数计数分别为 5B 和 8B,但通过分层嵌入,这些参数的很大一部分(与每个层相关联的嵌入)可以在 CPU 上高效地加载和计算。这意味着在通常受限的加速器内存 (VRAM) 中,只需容纳核心转换器的权重(E2B 约为 2B,E4B 约为 4B)。

处理长输入(例如源自音频和视频流的序列)对于许多先进的设备端多模态应用至关重要。Gemma 3n 引入了 KV 缓存共享功能,该功能旨在极大缩短加快流式响应应用的首字延迟时间。

KV 缓存共享优化了模型处理初始输入处理阶段(通常称为“预填充”阶段)的方式。来自局部和全局关注的中间层的键和值直接与所有顶层共享,与 Gemma 3 4B 相比,预填充性能显着提升了 2 倍。这意味着该模型可以比以前更快地注入和理解冗长的提示序列。

Gemma 3n 使用基于通用语音模型 (USM) 的高级音频编码器。编码器为每 160ms 的音频(每秒约 6 个词元)生成一个词元,然后将其作为输入集成到语言模型中,从而提供声音上下文的粒度表征。

这种集成的音频功能解锁了设备端开发的多种关键功能,包括:

我们观察到,对于英语和西班牙语、法语、意大利语及葡萄牙语之间的翻译,AST 的效果尤其强大,为针对这些语言的应用开发者提供了巨大潜力。对于语音翻译等任务,利用思维链提示可以显着改进结果。以下是一个示例:

<bos><start_of_turn>user

用西班牙语转录以下语音片段,然后将其翻译成英语:

<start_of_audio><end_of_turn>

<start_of_turn>model截至发布时,Gemma 3n 编码器可处理长达 30 秒的音频片段。然而,这并不是一个根本上的限制。底层的音频编码器是一种流式编码器,通过额外的长格式音频训练,编码器可以处理任意长度的音频。后续实现将解锁延迟更低、时间更长的流媒体应用。

除了集成的音频功能外,Gemma 3n 还具有全新的高效视觉编码器 MobileNet-V5-300M,可为边缘设备上的多模态任务提供最先进的性能。

MobileNet-V5 旨在为受限的硬件赋予灵活性和强大功能,为开发者提供:

这种级别性能的实现基于多种架构创新,包括:

得益于新颖的架构设计和先进的蒸馏技术,MobileNet-V5-300M 在 Gemma 3 中的性能大大优于基准 SoViT(使用 SigLip 训练,无蒸馏)。在 Google Pixel Edge TPU 上,该编码器在有量化情况下提速 13 倍(无量化时为 6.5 倍),所需参数减少 46 %,内存占用减少为原来的 1/4,同时在视觉语言任务上的准确性显着提升

我们很期待与大家分享该模型的更多研发工作。请留意我们即将发布的 MobileNet-V5 技术报告,该报告将深入探讨模型架构、数据扩展策略和先进的蒸馏技术。

让开发者在 Gemma 3n 发布的第一时间享受到该模型是我们的第一要务。我们有幸能与许多出色的开源开发者合作,确保模型能在多个热门工具和平台得到广泛支持,众多工具/平台的研发团队也为此做出了重要贡献,包括 AMD、Axolotl、Docker、Hugging Face、llama.cpp、LMStudio、MLX、NVIDIA、Ollama、RedHat、SGLang、Unsloth 和 vLLM 等。

但这个生态系统仅仅是开始。这项技术的真正力量在于用它构建的成果。正因如此,我们推出了“Gemma 3n 影响力挑战赛”。您的任务是使用 Gemma 3n 独特的在线、离线和多模态功能构建产品,从而让世界更美好。提交引人入胜的视频介绍,并通过令人惊艳的演示展现产品的真实影响力,就有机会赢取 15 万美元的奖金!欢迎加入挑战,共创美好未来。

准备好即刻探索 Gemma 3n 的潜力了吗?请查收以下攻略:

Unlock Gemini’s reasoning: A step-by-step guide to logprobs on Vertex AI

Simplify your Agent "vibe building" flow with ADK and Gemini CLI

Build with Veo 3, now available in the Gemini API

LLM 多语言创新:开放式模型如何助力解锁全球沟通

T5Gemma:全新 Encoder-Decoder 架构的 Gemma 模型系列